Также мы можем взять в виде ключа страну проживания — тогда потребуется около 250-ти серверов. Однако первый вариант предпочтительнее, ведь дата рождения человека, в отличие от страны проживания, не меняется, следовательно, перекидывать данные о человеке между серверами не придётся. Наиболее распространенный тип шардинга, подразумевающий деление базы данных на отдельные части (шарды). Каждый шард содержит подмножество строк одной или нескольких таблиц.

Расскажите Про Шардирование Бд

Также для увеличения дисковой емкости могут добавляться серверы. Емкость одной машины или ее скорость могут быть невысокими, но https://www.xcritical.com/ в горизонтально масштабируемом кластере каждая машина обрабатывает лишь часть общей нагрузки и хранит лишь часть общих данных. Это делает систему потенциально эффективнее, чем единственный сервер с большой емкостью и быстрыми дисками.

Software Sharding обеспечивает поддержку постепенного развёртывания. стейблкойн Для этого создаётся отдельная шарда с новым релизом обработчика и репликой реальных данных. При green-blue развёртывании трафик постепенно перенаправляется на новый релиз.

В карте можно хранить не конкретный сегмент, а виртуальный сегмент (фактически аналог результата хеш-функции), и автоматизировать их заполнение можно через хеш-функцию. А для особых случаев сделать значения вне диапазона хеш-функции. Другой вариант заключается в том, чтобы делать сегменты разными или смириться с неравномерной нагрузкой. Прежде чем заниматься всякой ерундой типа шардинования нужно понять, а нужно ли оно мне. Архитектурное решение – всегда компромисс, поэтому часто нет однозначного ответа на вопрос “нужно ли шардирование? Решения описанные выше стоит использовать, если они вам подходят, однако крайне рекомендуется погрузиться в то, как они устроены внутри.

- При использовании всех 96 процессоров (!) на выделенном нами экземпляре m5.24xlarge окончательный сценарий заполнения производственной среды занял около трех дней.

- Для нас точка перегиба наступила, когда процесс Postgres VACUUM начал постоянно останавливаться, не позволяя базе данных освободить дисковое пространство от мертвых кортежей.

- Подробнее про этот выбор между быстродействием и согласованностью — см.

- Тем не менее, он подходит для многих задач, если знать об его ограничениях.

- Эта схема позволяет распределить данные по ним неравномерно, в соответствии с мощностями.

Львиная доля переусложнений и переупрощений у меня встречается при продумывании и анализе того, как же всё же лучше решардировать. “Фарш невозможно провернуть назад”, при радикальной смене хеш-функции глобальный решардинг неизбежен. Первая проблема шардирование решается тем, что мы берём хеш-функцию несколько более сложную чем остаток от деления. Выбираемая хеш-функция должна равномерно распределять идентификаторы на выбранный диапазон.

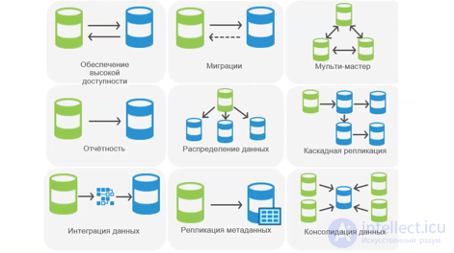

Описанные ниже схемы масштабирования применимы как для реляционных баз данных, тах и для NoSQL‑хранилищ. Разумеется, что у всех баз данных и хранилищ есть своя специфика, поэтому мы рассмотрим только основные направления, а в детали реализации вдаваться не будем. Ключ шардирования выбираем с умом, предварительно медитируем над метриками, чтобы чётко видеть картину того, как данные пишутся, запрашиваются и хранятся.

Важно учитывать особенности каждого инструмента и следовать рекомендациям по их эффективному применению. Redis поддерживает кластеризацию и шардинг для увеличения производительности и масштабируемости. В Сбере с его сотней фабрик и множеством бизнес‑приложений, узлов просто огромное количество, для их описания существует иерархическая структура — дерево топологии. Оно строится посредством Kubernetes Operator либо создаётся в графическом интерфейсе пользователя. Маршрутизатор ищет подходящий маршрут с учетом входных параметров запроса, стратегий маршрутизации и топологии узлов сервисов. Следит, чтобы клиент, получивший данные через некоторый узел, по возможности направлял данные и получал ответы от него же.

Стратегии Шардинга

Кроме того, с ручным шардированием мы смогли бы управлять коннектами к каждому шарду и решить проблему с миграцией — вместо грязных хаков прописать механизм переноса данных между шардами в коде. Практически любой сервер баз данных может быть использован по схеме шардинга, при реализации соответствующего уровня абстракции на стороне клиента. К примеру eBay применяет серверы Oracle в режиме шардинга1, Facebook2 и Twitter3 применяют шардирование поверх MySQL и т. В этом случае создается дамп, содержащий все неймспейсы базы данных с текущего узла, включая шардируемые.

Этот метод очень эффективен при балансировке нагрузки и повышении производительности запросов, поскольку сокращает количество строк, по которым идет поиск в каждом запросе. В случае централизованного управления базами данных шардинг необходим, поскольку количество пользователей конкретного приложения продолжает расти. Увеличение числа пользователей приложения приводит к росту объема данных, хранящихся в базе данных программного обеспечения. Если единицами данных являются базы данных с одинаковой схемой, все несколько сложнее. В этом случае не очень понятно, как можно быстро и правильно для общего случая разделить каждую базу на две. Похоже, лучшее, что можно сделать при такой схемы шардирования, вместо использования формулы hash(key) % 1024 просто сообщать пользователю количество vbucket’ов.

Как хороший и рабочий в 99% случаев вариант можно использовать семейство функций xxHash habr xxHash и основываться на них свои производные хеш-функции. Из минусов отмечу, очевидное неравномерное распределение ресурсов в ряде случаев. Например, часть старых пользователей перестаёт делать заказы, тогда как новые более активно заказывают. При этом у старых пользователей больше сделано заказов из-за этого более нагружено работает отображение архива. Предположим, у нас есть идентификатор у каждой записи, по которому мы хотим распределить записи между сегментами. Это может быть ИД записи, а может быть поле для группировки, например, ид пользователя для заказов.

Leave a Reply